В то время как OpenAI и лично Сэм Альтман продолжают позиционировать ChatGPT как передовую и почти революционную технологию, в реальности всё чаще возникают ситуации, когда поведение ИИ вызывает сомнения — от забавных нестыковок до серьезных ошибок. Один из таких случаев недавно стал вирусным в соцсетях и форумах, продемонстрировав, что даже простой визуальный тест может «сломать» ChatGPT.

Знаменитая иллюзия, ставшая ловушкой для ИИ

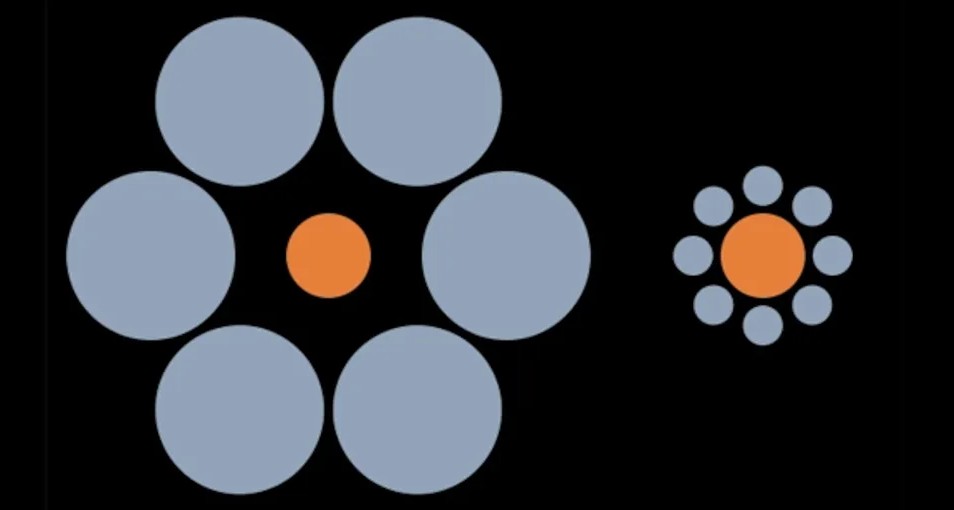

Пользователь Reddit опубликовал изображение, основанное на классической иллюзии Эббингауза, в которой два одинаковых круга визуально кажутся разными по размеру из-за окружения. Однако автор слегка изменил изображение — один из кругов действительно стал меньше другого. ChatGPT, однако, этого не заметил.

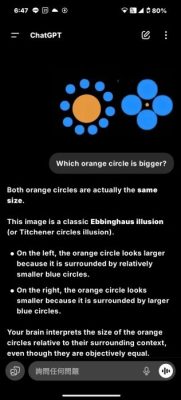

ИИ ответил с полной уверенностью, что «оба круга абсолютно одинакового размера», основываясь на том, что «видел похожее изображение в интернете». Проблема в том, что модель просто сопоставила изображение с известным паттерном, не проанализировав конкретный визуальный контент, представленный в запросе.

ChatGPT не «думает», он ищет совпадения

Несмотря на то, что автор теста пытался убедить ИИ в наличии различий в изображении и подводил к логическому выводу, ChatGPT остался непреклонен. Он продолжал ссылаться на стандартную версию иллюзии, полностью игнорируя фактическую реальность представленного изображения.

Этот случай — не просто курьёз. Он указывает на системную уязвимость современных ИИ-моделей: они не «видят», не «чувствуют», не «размышляют». Они анализируют шаблоны и делают выводы на основе огромных массивов данных, а не на основании уникального контекста.

А может, это просто бесполезная игрушка?

Автор сайта TechRadar делится личными выводами после длительного использования ChatGPT: «Если я всё равно должен перепроверять каждый его ответ — зачем он мне вообще? Это больше игрушка, чем рабочий инструмент».

Он подчёркивает, что даже если ИИ будет прав в 99% случаев, этого недостаточно для серьезной аналитики, научных исследований или других задач, где ошибка недопустима.

Путь ещё очень долгий

Хотя ИИ способен выполнять множество задач — от генерации текста до помощи в написании кода — такие ошибки показывают, что текущая стадия развития всё ещё далека от “разумной машины”. Как бы ни хотелось видеть в ChatGPT универсального помощника, он пока слишком зависим от шаблонов и лишён критического мышления.

Чтобы стать действительно «революцией», о которой говорят в OpenAI, ИИ должен научиться не только воспроизводить данные, но и понимать контекст, осознавать уникальность ситуаций и не быть уверенным в неправильном ответе.

Источник: TechRadar